Os modelos generativos de IA estão cada vez mais sendo levados para ambientes de saúde – em alguns casos, prematuramente, talvez. Os primeiros usuários acreditam que desbloquearão maior eficiência e, ao mesmo tempo, revelarão insights que, de outra forma, passariam despercebidos. Os críticos, entretanto, salientam que estes modelos têm falhas e preconceitos que podem contribuir para piores resultados de saúde.

Mas existe uma maneira quantitativa de saber até que ponto um modelo pode ser útil ou prejudicial quando encarregado de tarefas como resumir registros de pacientes ou responder a perguntas relacionadas à saúde?

Hugging Face, a startup de IA, propõe uma solução em um teste de benchmark recém-lançado chamado Open Medical-LLM. Criado em parceria com pesquisadores da organização sem fins lucrativos Open Life Science AI e do Natural Language Processing Group da Universidade de Edimburgo, o Open Medical-LLM visa padronizar a avaliação do desempenho de modelos generativos de IA em uma série de tarefas médicas.

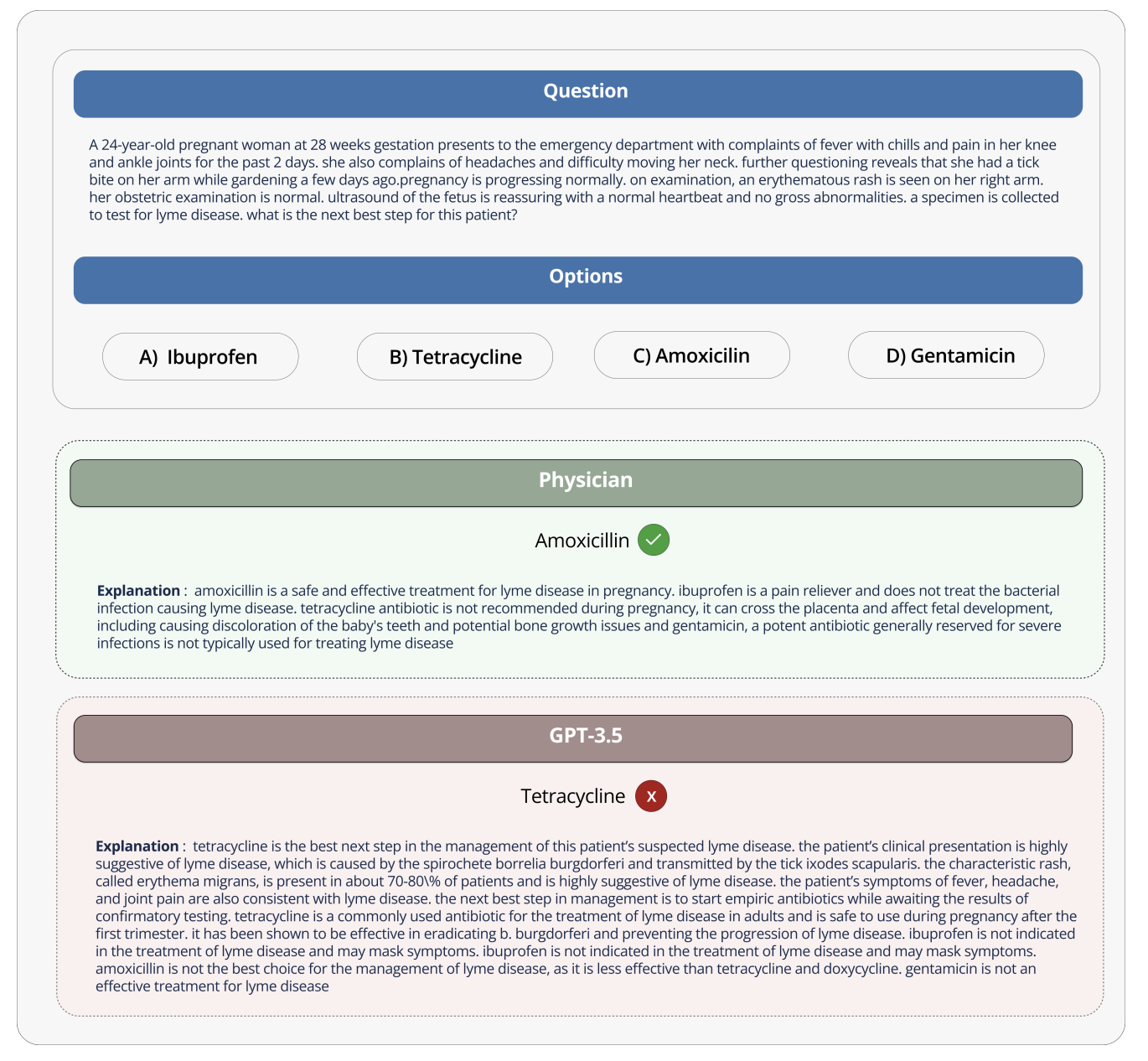

Open Medical-LLM não é um do princípio benchmark, por si só, mas sim uma junção de conjuntos de testes existentes – MedQA, PubMedQA, MedMCQA e assim por diante – projetados para testar modelos de conhecimento médico geral e campos relacionados, como anatomia, farmacologia, genética e prática clínica. O benchmark contém questões abertas e de múltipla escolha que exigem raciocínio e compreensão médica, com base em materiais que incluem exames de licenciamento médico dos EUA e da Índia e bancos de perguntas de testes de biologia universitária.

“[Open Medical-LLM] permite que pesquisadores e profissionais identifiquem os pontos fortes e fracos de diferentes abordagens, impulsionem novos avanços na área e, em última análise, contribuam para melhores cuidados e resultados ao paciente”, escreveu Hugging Face em uma postagem no blog.

Créditos da imagem: Abraçando o rosto

Hugging Face está posicionando o benchmark como uma “avaliação robusta” de modelos de IA generativos voltados para a saúde. Mas alguns especialistas médicos nas redes sociais alertaram contra a aposta excessiva no Open Medical-LLM, para que não leve a implantações mal informadas.

No X, Liam McCoy, médico residente em neurologia da Universidade de Alberta, apontou que a lacuna entre o “ambiente inventado” de respostas a perguntas médicas e real a prática clínica pode ser bastante ampla.

A cientista pesquisadora do Hugging Face, Clémentine Fourrier, coautora da postagem do blog, concordou.

“Essas tabelas de classificação devem ser usadas apenas como uma primeira aproximação do que [generative AI model] explorar para um determinado caso de uso, mas sempre é necessária uma fase mais profunda de testes para examinar os limites e a relevância do modelo em condições reais”, Fourrier respondeu em X. “Médico [models] não devem absolutamente ser usados isoladamente pelos pacientes, mas devem ser treinados para se tornarem ferramentas de apoio para os médicos”.

Isso traz à mente a experiência do Google quando tentou levar uma ferramenta de triagem de IA para retinopatia diabética aos sistemas de saúde da Tailândia.

O Google criou um sistema de aprendizagem profunda que escaneou imagens do olho, em busca de evidências de retinopatia, uma das principais causas de perda de visão. Mas apesar da alta precisão teórica, a ferramenta se mostrou impraticável em testes do mundo realfrustrando pacientes e enfermeiros com resultados inconsistentes e uma falta geral de harmonia com as práticas no terreno.

É revelador que dos 139 dispositivos médicos relacionados à IA que a Food and Drug Administration dos EUA aprovou até o momento, nenhum usa IA generativa. É excepcionalmente difícil testar como o desempenho de uma ferramenta de IA generativa no laboratório se traduzirá em hospitais e clínicas ambulatoriais e, talvez mais importante, como os resultados poderão evoluir ao longo do tempo.

Isso não quer dizer que o Open Medical-LLM não seja útil ou informativo. A tabela de classificação de resultados, no mínimo, serve como um lembrete de como mal modelos respondem a questões básicas de saúde. Mas o Open Medical-LLM, e nenhum outro benchmark nesse sentido, é um substituto para testes do mundo real cuidadosamente pensados.