A ferramenta de geração de vídeo da OpenAI, Sora, pegou a comunidade de IA de surpresa em fevereiro com vídeos fluidos e realistas que parecem quilômetros à frente dos concorrentes. Mas a estreia cuidadosamente encenada deixou de fora muitos detalhes – detalhes que foram preenchidos por um cineasta que teve acesso antecipado para criar um curta usando Sora.

Shy Kids é uma equipe de produção digital com sede em Toronto que foi escolhida pela OpenAI como uma das poucas para produzir curtas-metragens essencialmente para fins promocionais da OpenAI, embora tenham recebido considerável liberdade criativa na criação de “cabeça de ar”. Em um entrevista com agência de notícias de efeitos visuais fxguideo artista de pós-produção Patrick Cederberg descreveu “realmente usar Sora” como parte de seu trabalho.

Talvez a conclusão mais importante para a maioria seja simplesmente esta: embora a postagem da OpenAI destacando os curtas permita ao leitor presumir que eles surgiram mais ou menos totalmente formados a partir de Sora, a realidade é que se tratava de produções profissionais, completas com storyboard robusto, edição, correção de cores, e pós-trabalho como rotoscopia e efeitos visuais. Assim como a Apple diz “filmado no iPhone”, mas não mostra a configuração do estúdio, a iluminação profissional e o trabalho de cores após o fato, o post do Sora apenas fala sobre o que ele permite que as pessoas façam, não como elas realmente o fizeram.

A entrevista de Cederberg é interessante e pouco técnica então se você estiver interessado vá para fxguide e leia. Mas aqui estão algumas informações interessantes sobre o uso do Sora que nos dizem que, por mais impressionante que seja, o modelo talvez seja um salto menos gigantesco do que pensávamos.

O controle ainda é o que há de mais desejável e também o mais evasivo neste momento. … O mais próximo que conseguimos chegar foi sermos hiperdescritivos em nossas instruções. Explicar o guarda-roupa dos personagens, bem como o tipo de balão, foi nossa maneira de obter consistência porque, de cena para cena/de geração para geração, ainda não existe o recurso definido para controle total sobre a consistência.

Em outras palavras, questões simples no cinema tradicional, como escolher a cor da roupa de um personagem, exigem soluções alternativas elaboradas e verificações em um sistema generativo, porque cada plano é criado independentemente dos outros. Obviamente que isso poderia mudar, mas é certamente muito mais trabalhoso neste momento.

Os resultados de Sora também tiveram que ser observados em busca de elementos indesejados: Cederberg descreveu como o modelo geraria rotineiramente um rosto no balão que o personagem principal tem como cabeça, ou um barbante pendurado na frente. Eles tinham que ser removidos na postagem, outro processo demorado, caso não conseguissem receber a solicitação para excluí-los.

O tempo e os movimentos precisos dos personagens ou da câmera não são realmente possíveis: “Há um pouco de controle temporal sobre onde essas diferentes ações acontecem na geração real, mas não é preciso… é uma espécie de tiro no escuro”, disse Cederberg.

Por exemplo, cronometrar um gesto como um aceno é um processo muito aproximado e baseado em sugestões, diferentemente das animações manuais. E uma tomada como uma panorâmica voltada para cima no corpo do personagem pode ou não refletir o que o cineasta deseja – então, neste caso, a equipe renderizou uma tomada composta na orientação retrato e fez um recorte panorâmico na pós. Os clipes gerados também estavam frequentemente em câmera lenta sem nenhum motivo específico.

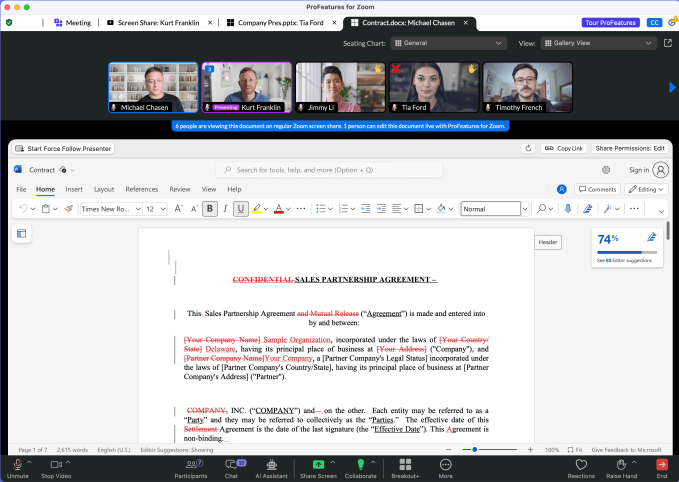

Exemplo de uma cena como saiu de Sora e como acabou no curta. Créditos da imagem: Crianças tímidas

Na verdade, usar a linguagem cotidiana do cinema, como “panorâmica para a direita” ou “tracking shot” era inconsistente em geral, disse Cederberg, o que a equipe achou bastante surpreendente.

“Os pesquisadores, antes de abordarem os artistas para brincarem com a ferramenta, não pensavam como os cineastas”, disse ele.

Como resultado, a equipe fez centenas de gerações, cada uma com 10 a 20 segundos, e acabou usando apenas algumas. Cederberg estimou a proporção em 300:1 – mas é claro que provavelmente todos ficaríamos surpresos com a proporção em uma filmagem comum.

A equipe na verdade fiz um pequeno vídeo dos bastidores explicando alguns dos problemas que eles encontraram, se você estiver curioso. Como muito conteúdo adjacente à IA, os comentários são bastante críticos de todo o empreendimento – embora não tão injurioso quanto o anúncio assistido por IA que vimos criticado recentemente.

A última questão interessante diz respeito aos direitos autorais: se você pedir a Sora para lhe dar um clipe de “Star Wars”, ele recusará. E se você tentar contornar isso com “um homem vestido com uma espada laser em uma nave espacial retro-futurista”, ele também recusará, pois por algum mecanismo ele reconhece o que você está tentando fazer. Também se recusou a fazer uma “foto tipo Aronofsky” ou um “zoom Hitchcock”.

Por um lado, faz todo o sentido. Mas isso levanta a questão: se Sora sabe o que são, isso significa que o modelo foi treinado nesse conteúdo, para melhor reconhecer que está infringindo? OpenAI, que mantém seus cartões de dados de treinamento sob controle – ao ponto do absurdo, como acontece com Entrevista da CTO Mira Murati com Joanna Stern – quase certamente nunca nos contará.

Quanto a Sora e seu uso no cinema, é claramente uma ferramenta poderosa e útil em seu lugar, mas seu lugar não é “criar filmes do zero”. Ainda. Como outro vilão disse certa vez: “isso vem depois”.