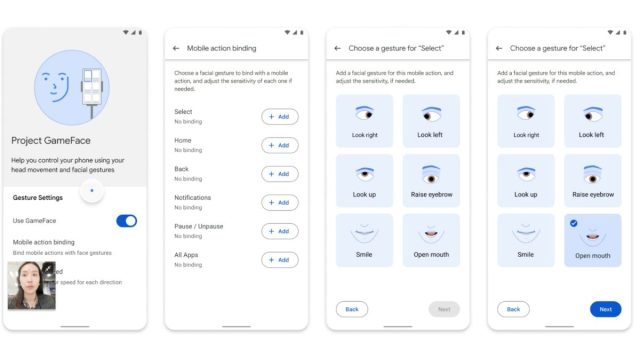

O Google expandiu seu Projeto Gameface, um projeto de código aberto que visa tornar os dispositivos tecnológicos mais acessíveis, para Android, e agora pode ser usado para controlar a interface do smartphone. O projeto foi apresentado pela primeira vez durante o Google I/O 2023 como um mouse para jogos com viva-voz que pode ser controlado por meio de movimentos da cabeça e expressões faciais. Eles foram projetados para quem sofre de deficiência física e não pode usar as mãos ou a voz para controlar dispositivos. Mantendo o mesmo funcionamento, a versão Android adiciona um cursor virtual para permitir ao usuário controlar seu dispositivo sem tocá-lo.

Em um anúncio feito em seu blog voltado para desenvolvedores publicar, O Google disse: “Estamos abrindo o código-fonte de mais código para o Projeto Gameface para ajudar os desenvolvedores a criar aplicativos Android para tornar cada dispositivo Android mais acessível. Através da câmera do dispositivo, ele rastreia perfeitamente as expressões faciais e os movimentos da cabeça, traduzindo-os em um controle intuitivo e personalizado.” Além disso, a empresa pediu aos desenvolvedores que usassem as ferramentas para adicionar recursos de acessibilidade aos seus aplicativos também.

O Projeto Gameface colaborou com a organização indiana Incluzza que apoia pessoas com deficiência. Usando a colaboração, o projeto aprendeu como suas tecnologias podem ser expandidas para diferentes casos de uso, como digitar uma mensagem, procurar emprego e muito mais. Ele usou a API Face Landmarks Detection da MediaPipe e o serviço de acessibilidade do Android para criar um novo cursor virtual para dispositivos Android. O cursor se move seguindo o movimento da cabeça do usuário após rastreá-lo usando a câmera frontal.

A API reconhece 52 gestos faciais, incluindo levantar uma sobrancelha, abrir a boca, mover os lábios e muito mais. Esses 52 movimentos são usados para controlar e mapear uma ampla gama de funções no dispositivo Android. Um recurso interessante é arrastar. Os usuários podem usar isso para deslizar a tela inicial. Para criar um efeito de arrastar, os usuários terão que definir um ponto inicial e final. Pode ser algo como abrir a boca e mover a cabeça e, uma vez alcançado o ponto final, fechar a boca novamente.

Notavelmente, embora esta tecnologia tenha sido disponibilizada no GitHub, agora cabe aos desenvolvedores construir aplicativos usando esta opção para torná-la mais acessível aos usuários. A Apple também introduziu recentemente um novo recurso que usa rastreamento ocular para controlar o iPhone.