A IA generativa projetada para a empresa (por exemplo, IA que preenche automaticamente relatórios, fórmulas de planilhas e assim por diante) pode ser interoperável? Juntamente com um grupo de organizações, incluindo Cloudera e Intel, a Linux Foundation – a organização sem fins lucrativos que apoia e mantém um número crescente de esforços de código aberto – pretende descobrir.

A Fundação Linux hoje anunciado o lançamento da Plataforma Aberta para IA Empresarial (OPEA), um projeto para promover o desenvolvimento de sistemas de IA generativos abertos, multifornecedores e combináveis (ou seja, modulares). Sob a alçada da LFAI and Data org da Linux Foundation, que se concentra em iniciativas de plataformas relacionadas à IA e a dados, o objetivo da OPEA será preparar o caminho para o lançamento de sistemas de IA generativos “fortes” e “escaláveis” que “aproveitem o melhor inovação de código aberto em todo o ecossistema”, disse o diretor executivo da LFAI e Data, Ibrahim Haddad, em um comunicado à imprensa.

“A OPEA irá desbloquear novas possibilidades em IA, criando uma estrutura detalhada e combinável que está na vanguarda das pilhas de tecnologia”, disse Haddad. “Esta iniciativa é uma prova da nossa missão de impulsionar a inovação e a colaboração de código aberto nas comunidades de IA e de dados sob um modelo de governança neutro e aberto.”

Além de Cloudera e Intel, OPEA – um dos projetos Sandbox da Linux Foundation, uma espécie de programa de incubadora – conta entre seus membros pesos pesados como Intel, Red Hat, de propriedade da IBM, Hugging Face, Domino Data Lab, MariaDB e VMWare.

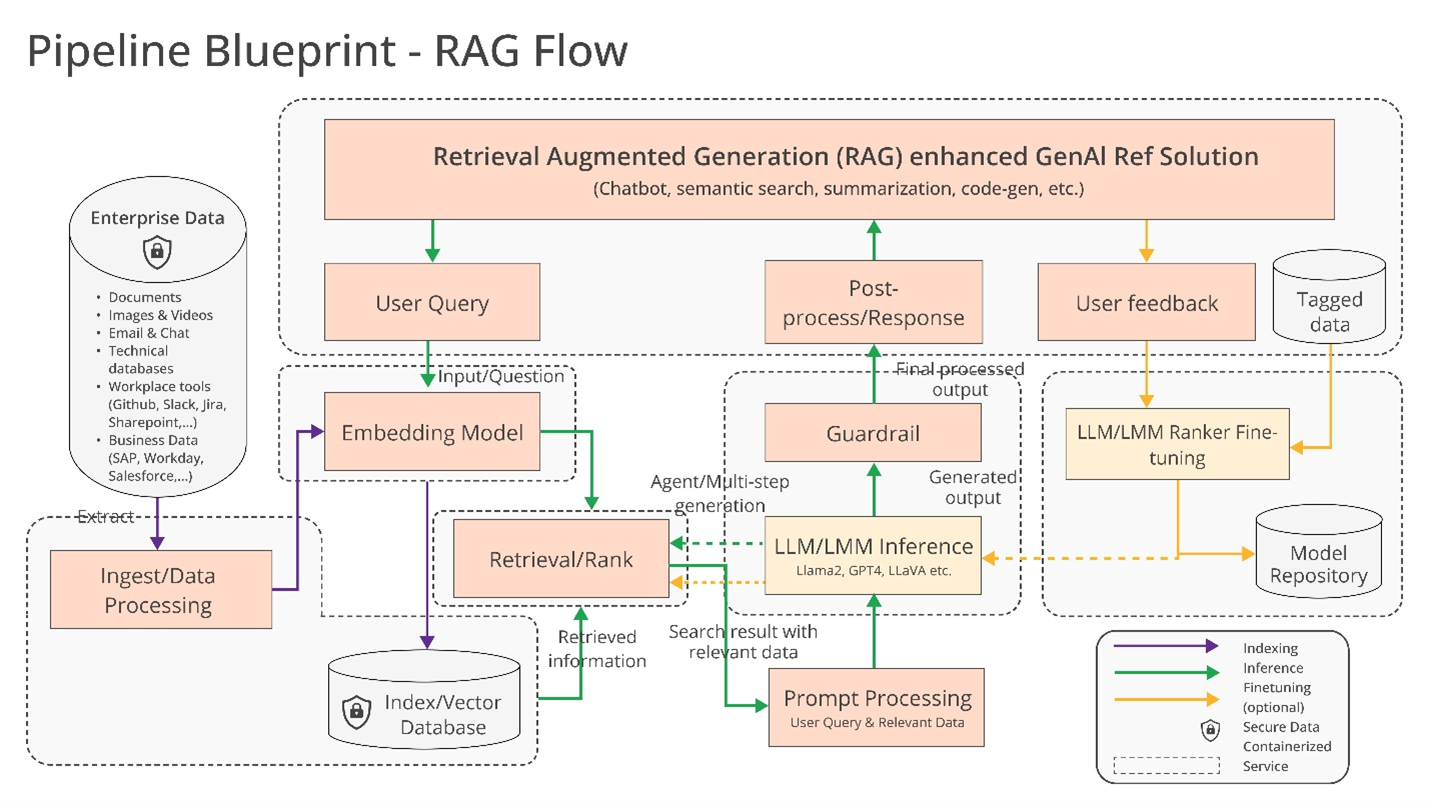

Então, o que eles poderiam construir juntos exatamente? Haddad sugere algumas possibilidades, como suporte “otimizado” para conjuntos de ferramentas e compiladores de IA, que permitem que cargas de trabalho de IA sejam executadas em diferentes componentes de hardware, bem como pipelines “heterogêneos” para geração aumentada de recuperação (RAG).

O RAG está se tornando cada vez mais popular em aplicações empresariais de IA generativa e não é difícil perceber porquê. As respostas e ações da maioria dos modelos de IA generativos são limitadas aos dados nos quais são treinados. Mas com o RAG, a base de conhecimento de um modelo pode ser estendida para informações fora dos dados de treinamento originais. Os modelos RAG fazem referência a essas informações externas – que podem assumir a forma de dados proprietários da empresa, um banco de dados público ou alguma combinação dos dois – antes de gerar uma resposta ou executar uma tarefa.

Um diagrama explicando os modelos RAG.

A Intel ofereceu mais alguns detalhes por conta própria Comunicado de imprensa:

As empresas são desafiadas com uma abordagem do tipo “faça você mesmo” [to RAG] porque não existem padrões de facto entre componentes que permitam às empresas escolher e implementar soluções RAG que sejam abertas e interoperáveis e que as ajudem a chegar rapidamente ao mercado. A OPEA pretende abordar estas questões colaborando com a indústria para padronizar componentes, incluindo estruturas, projetos de arquitetura e soluções de referência.

A avaliação também será uma parte fundamental do que a OPEA aborda.

Em seu GitHub repositórioa OPEA propõe uma rubrica para classificar sistemas de IA generativos em quatro eixos: desempenho, recursos, confiabilidade e prontidão de “nível empresarial”. Desempenho como a OPEA define, refere-se a benchmarks de “caixa preta” de casos de uso do mundo real. Características é uma avaliação da interoperabilidade, opções de implantação e facilidade de uso de um sistema. A confiabilidade analisa a capacidade de um modelo de IA de garantir “robustez” e qualidade. E prontidão empresarial concentra-se nos requisitos para colocar um sistema em funcionamento e sem grandes problemas.

Rachel Roumeliotis, diretora de estratégia de código aberto da Intel, diz que a OPEA trabalhará com a comunidade de código aberto para oferecer testes baseados na rubrica – e fornecer avaliações e classificações de implantações de IA generativa, mediante solicitação.

Os outros esforços da OPEA estão um pouco incertos neste momento. Mas Haddad lançou o potencial de desenvolvimento de modelo aberto nos moldes da família Llama em expansão da Meta e do DBRX da Databricks. Para esse fim, no repositório OPEA, a Intel já contribuiu com implementações de referência para um chatbot generativo alimentado por IA, resumidor de documentos e gerador de código otimizado para seu hardware Xeon 6 e Gaudi 2.

Agora, os membros da OPEA estão claramente investidos (e interessados, aliás) na construção de ferramentas para IA generativa empresarial. Cloudera recentemente parcerias lançadas para criar o que está apresentando como um “ecossistema de IA” na nuvem. Domino oferece um conjunto de aplicativos para construir e auditar IA generativa voltada para negócios. E o VMWare – orientado para o lado da infraestrutura da IA corporativa – foi lançado em agosto passado novos produtos de computação de “IA privada”.

A questão é – no âmbito da OPEA – estes fornecedores na verdade trabalhar juntos para construir ferramentas de IA compatíveis entre si?

Há um benefício óbvio em fazer isso. Os clientes terão prazer em recorrer a vários fornecedores, dependendo de suas necessidades, recursos e orçamentos. Mas a história mostra que é muito fácil ficar inclinado ao aprisionamento do fornecedor. Esperemos que esse não seja o resultado final aqui.